News - Дезинформация от ИИ порождает расовые напряженности и оказывает политическое влияние

Business Strategy

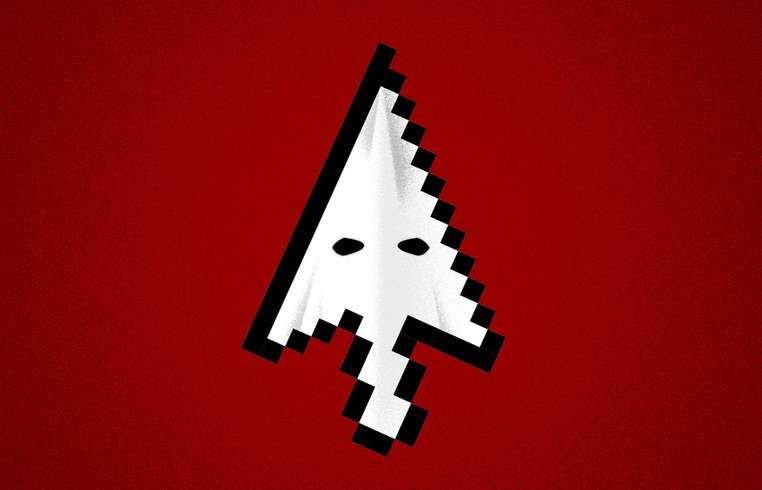

Дезинформация от ИИ порождает расовые напряженности и оказывает политическое влияние

В развивающемся мире искусственного интеллекта создание и распространение видео, сгенерированных ИИ, становится пугающе простым и убедительным. Эта легкость фальсификации, с использованием таких инструментов, как Sora от OpenAI и VEO 3 от Google, способствует распространению искусственного контента, который становится все труднее отличить от подлинных медиа. Эти достижения породили новое цифровое явление, напоминающее 'чернолицо', когда люди, не принадлежащие к темнокожим, создают видео-персонажи черного или коричневого цвета кожи, чтобы получить социальные ценности, такие как лайки, репосты, а в некоторых случаях, и материальную выгоду. Эта тенденция внушает беспокойство, особенно в условиях, когда платформы социальных сетей поощряют создание контента через доходы от просмотра. Опасность этих видео, созданных ИИ, заключается не только в их обманчивом характере, но и в их потенциале для сохранения расовых стереотипов и влияния на общественное восприятие. Серия фальшивых видео, в которых якобы темнокожие женщины обсуждают злоупотребление программой помощи SNAP во время закрытия правительства, вызвала волну ненависти в интернете. Эти видео поддержали вредный стереотип о темнокожих женщинах как 'королевах социального обеспечения', что, к сожалению, привело часть пользователей к негативным настроениям против программы SNAP. Удивительно, но статистические данные опровергают этот нарратив, показывая, что большинство получателей SNAP — не испаноязычные белые люди. Тем не менее, привлекательность контента, который, казалось бы, подтверждает предвзятые убеждения, часто заставляет пользователей игнорировать факты в пользу эмоционального отклика. Эта динамика подчеркивает мощное влияние дезинформации на социальных платформах. Майкл Хаггинс из группы за расовую справедливость Color of Change отметил психологическое воздействие такого поддельного контента. Даже когда зрители определяют контент как ложный, его отрицательные коннотации могут ненароком проникнуть в коллективное сознание, формируя отношение к реальным вопросам, включая политические выборы. Хотя некоторые технологические компании предпринимают шаги по ограничению распространения манипулятивного контента, внедряя политику против языка ненависти и дезинформации, остаются значительные резервы для улучшений. OpenAI и Google ввели различные меры безопасности, такие как запрет использования обидных слов и внедрение цифровых водяных знаков, сигнализирующих о контенте, сгенерированном ИИ. Тем не менее, охват и влияние этих видео продолжают представлять значительные проблемы. По словам организационного психолога Джанис Гассам Асаре, легкомысленное отношение к такому контенту является именно тем, что делает его настолько опасным. Она призывает потребителей социальных сетей к разборчивости, поощряя критическую оценку подлинности контента. Это продолжающееся сражение с дезинформацией, основанной на ИИ, отражает более широкие тенденции в цифровой трансформации и социально-политической динамике, подчеркивая настоятельную необходимость повышения осведомленности и ответственности платформ для защиты общественных ценностей и демократических процессов.