News - اطلاعات نادرست توسط هوش مصنوعی باعث تنشهای نژادی و تأثیرات سیاسی میشود

Business Strategy

اطلاعات نادرست توسط هوش مصنوعی باعث تنشهای نژادی و تأثیرات سیاسی میشود

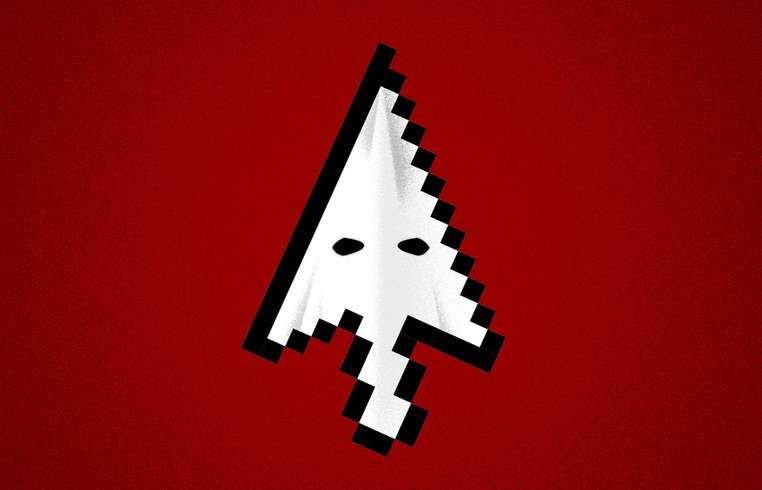

در چشمانداز در حال تکامل هوش مصنوعی، ایجاد و انتشار ویدئوهای تولیدشده توسط هوش مصنوعی به طور نگرانکنندهای بدون نقص و متقاعدکننده شدهاند. این سهولت در تولید، با بهرهگیری از ابزارهایی مانند سورا از OpenAI و VEO 3 از گوگل، باعث افزایش محتوای مصنوعی شده که شناسایی آن از رسانههای اصیل بهطور فزایندهای دشوار است. این پیشرفتها پدیده دیجیتالی جدیدی را به وجود آوردهاند که به 'چهره سیاه' شباهت دارد، جایی که افراد غیرسیاهپوست ویدئوهای با شخصیت سیاه یا قهوهای ایجاد میکنند تا از ارز اجتماعی مانند لایک، اشتراکگذاری و در برخی موارد، کسب درآمد نقدی بهرهمند شوند. این روند پیامدهای نگرانکنندهای دارد، بهویژه از آنجایی که پلتفرمهای شبکههای اجتماعی محتواسازی را از طریق درآمد از بازدیدها تشویق میکنند. موذیانه بودن این ویدئوهای تولیدشده توسط هوش مصنوعی نه تنها در طبیعت فریبنده آنها نهفته است بلکه در توانایی آنها برای تکرار کلیشههای نژادی و تأثیر بر درک عمومی هم نهفته است. مجموعهای از ویدئوهای جعلی که زنان سیاهپوست ادعایی را نشان میدادند و درباره سوءاستفاده از خدمات دولتی SNAP در زمان تعطیلی دولت صحبت میکردند، موجی از نفرت را تحریک کردند. این ویدئوها کلیشه زیانآور 'ملکههای سرپرست' را تکرار کردند، تصوری که متأسفانه باعث شد برخی کاربران علیه برنامه SNAP موضعگیری کنند. نکته جالب اینجاست که دادههای آماری این روایت را با این واقعیت که اکثریت دریافتکنندگان SNAP افراد سفیدپوست غیر هیسپانیک هستند، نقض میکنند. با این حال، جذابیت محتوایی که به نظر میرسد تعصبهای قبلی را تأیید میکند، اغلب باعث میشود کاربران به جای توجه به حقایق، به سمت احساسات متناسب با آن گرایش پیدا کنند. این دینامیک تأثیر قدرتمند اطلاعات نادرست در پلتفرمهای اجتماعی را نشان میدهد. مایکل هاگینز از گروه عدالت نژادی Color of Change بر تأثیر روانی چنین محتوای جعلی تاکید کرد. حتی زمانی که بینندگان محتوایی را به عنوان نادرست شناسایی میکنند، معانی منفی آن میتواند ناخواسته به ذهنیتهای جمعی نفوذ کند و نگرشها نسبت به مسایل دنیای واقعی، از جمله انتخابات سیاسی را شکل دهد. در حالی که برخی از شرکتهای فناوری در حال پیشرفت برای کاهش انتشار محتوای دستکاری شده با ایجاد سیاستهایی علیه سخنان نفرتآمیز و اطلاعات نادرست هستند، هنوز جا برای بهبود وجود دارد. OpenAI و گوگل انواع محافظتهایی مانند ممنوعیت تهمتها و اجرای نشانهگذاری دیجیتال برای علامتگذاری محتوای تولیدشده توسط هوش مصنوعی را ایجاد کردهاند. با این حال، دسترسی و تأثیرات این ویدئوها همچنان چالشهای قابل توجهی را پیش رو قرار میدهند. طبق نظر جنیس گسام اساره، روانشناس سازمانی، بیاعتنایی که با آن اغلب به چنین محتواهایی توجه میشود، دقیقاً آن چیزی است که آنها را خطرناک میکند. او مردم مصرفکننده شبکههای اجتماعی را به دقت بیشتر در ارزیابی محتوای معتبر تشویق میکند. این نبرد مداوم علیه اطلاعات نادرست مبتنی بر هوش مصنوعی، به روندهای گستردهتر در تحول دیجیتال و پویاییهای اجتماعی-سیاسی اشاره دارد و بر ضرورت افزایش آگاهی و مسئولیتپذیری پلتفرمها برای حفظ ارزشهای اجتماعی و فرآیندهای دموکراتیک تاکید میکند.